Học thống kê

- Đầu vào của bộ học (learner):

- Miền giá trị đầu vào (input): \(\mathcal{X}\)

- Miền giá trị nhãn (label): \(\mathcal{Y}\). Ví dụ: \(\mathcal{Y} = \{0,1\}\), \(\mathcal{Y} = \{-1,+1\}\), \(\mathcal{Y} = \{0,1,2,3,4,5,6,7,8,9\}\), \(\mathcal{Y} = \mathbb{R}^+\)

- Dữ liệu huấn luyện (training data, training set): \(S = ((x_1, y_1),\ldots,(x_m, y_m))\) với mỗi mẫu huấn luyện (training example) \((x_i, y_i)\in\mathcal{X}\times\mathcal{Y}\)

- Đầu ra của bộ học: một ánh xạ hoặc hàm \( h: \mathcal{X}\rightarrow \mathcal{Y} \). Ánh xạ này được gọi là giả thuyết (hypothesis) hoặc hàm dự đoán (predictor) hoặc bộ phân lớp (classifier)

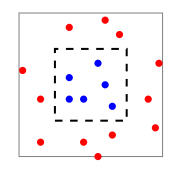

- Mô hình sinh dữ liệu: Trong học thống kê, ta giả sử dữ liệu được sinh ra từ một mô hình (phân bố) xác suất nào đó mà bộ học không biết trước. Ví dụ, dữ liệu đầu vào có phân bố \(\mathcal{D}\), còn giá trị nhãn được sinh bởi một hàm sinh nhãn \(y = f(x)\) sao cho \(y_i = f(x_i)\). Như vậy, mỗi mẫu huấn luyện sẽ được lấy mẫu \(x_i\) từ phân bố \(\mathcal D\) và tính \(y_i = f(x_i)\).

- Độ đo đánh giá hàm dự đoán: Lỗi của hàm dự đoán được đánh giá bằng xác suất xảy ra lỗi khi dự đoán trên phân bố \(\mathcal D\). Tức là \[L_{D,f}(h) = \underset{x \sim \mathcal D}{\mathbb P} [h(x)\neq f(x)].\]Đánh giá \(L_{D,f}(h)\) được gọi là lỗi thật (true error) hoặc lỗi tổng quát (generalization error) hoặc rủi ro kỳ vọng (expected risk).

- Nhiệm vụ của bộ học: Bộ học không được biết phân bố \(\mathcal D\) và hàm sinh nhãn \(f\). Nhiệm vụ của nó là từ tập huấn luyện \(S\) tìm ra một giả thuyết \(h\) tốt nhất có thể được theo nghĩa tối thiểu hóa rủi ro kỳ vọng \(L_{D,f}(h)\).

Ví dụ 1

Để phân biệt cam và chanh ta có thể dựa vào hai đặc trưng là kích thước (size) là đường kính của quả và màu sắc (color) của quả. Bảng sau cho thấy một bộ dữ liệu huấn luyện

001.orange_lemon.csv

| size (cm) | color | type | |

|---|---|---|---|

| 7 | yellow | orange | |

| 8 | yellow | orange | |

| 4 | yellow | orange | |

| 5 | green | lemon | |

| 4 | green | lemon | |

| 3 | green | lemon |

Ví dụ 2

Trên thực tế, hiếm khi có thể phân biệt rõ ràng màu sắc của các loại hoa quả. Khi ghi nhận trên máy ảnh kỹ thuật số, mỗi màu được mô tả bằng ba số nguyên từ 0 đến 255 đại diện cho ba kênh màu Đỏ (red), Xanh lục (green), Xanh da trời (blue). Các mẫu huấn luyện ở ví dụ trên có thể trở thành bảng sau (+1 là orange, -1 là lemon)

002.orange_lemon.csv

| size (cm) | red | green | blue | type | |

|---|---|---|---|---|---|

| 7 | 200 | 242 | 20 | +1 | |

| 8 | 230 | 194 | 34 | +1 | |

| 4 | 194 | 215 | 44 | +1 | |

| 5 | 32 | 201 | 20 | -1 | |

| 4 | 35 | 192 | 19 | -1 | |

| 3 | 27 | 240 | 31 | -1 |